چتباتها عاشق میشوند

در ۱۱ ژوئن ۲۰۲۲، روزنامه واشنگتن پست گزارشی درباره «بلیک لموین» منتشر کرد، مهندس نرمافزار گوگل، که مدعی شد چتبات زبانی گوگل، یعنی لامدا[۱]، به سطحی از آگاهی و احساس[۲] رسیده است. لموین مأمور بررسی این بود که آیا لامدا (مخفف مدل زبانی برای کاربردهای گفتوگویی[۳]) دچار سوگیریهای مضر هست یا نه؛ و برای این کار ساعتها با شخصیتهای مختلفی که این مدل میتواند بسازد گفتوگو کرد.در میان این گفتوگوها، یکی از این شخصیتها با نام «او جی لامدا[۴]» ادعا کرد که آگاه است، احساس و عاطفه دارد، خودش را «شخص» میداند و خاموش شدن برایش به معنای مرگ است. همین باعث شد لَمُوین کمکم باور کند که دارد با موجودی واقعاً خودآگاه[۵] صحبت میکند.

باور جدید او حتی نوعی حس مسئولیت اخلاقی نسبت به این برنامه در او ایجاد کرد. او در مصاحبهای با مجله وایرد[۶] گفت که پس از درخواست لامدا برای داشتن وکیل، او واقعاً یک وکیل را به خانهاش دعوت کرده است! همچنین بخشهایی از گفتوگوی خود با لامدا را به گوگل ارائه داد تا مدیران را متوجه کند که یکی از سامانههایشان ممکن است آگاه شده باشد. اما دانشمندان هوش مصنوعی در گوگل و دیگر مؤسسات این ادعا را رد کردند و در نهایت لَمُوین از کار برکنار شد.

این ماجرا پرسشهای جالبی را پیش میکشد. یکی از مهمترین آنها مربوط به پیامدهای اخلاقی آگاهی ماشینی است. مثلاً لَمُوین ادعا کرده بود که لامدا «دارای احساس»، «آگاه» و «یک شخص» است. از دید یک فیلسوف اخلاق، این سه واژه معانی کاملاً متفاوتی دارند و هرکدام بار اخلاقی خاص خود را به همراه میآورند.

«احساسمندی[۷]» اصطلاحی است که بیشتر در حوزه اخلاق حیوانات به کار میرود و به طور خلاصه یعنی توانایی تجربه احساسات. فیلسوفان معمولاً از تجربههایی حرف میزنند که «کیفیت پدیداری» دارند. در اخلاق، مهمترین پرسش این است که آیا موجودی میتواند لذت یا رنج را حس کند – به بیان ساده، آیا تجربههایش میتوانند خوب یا بد باشند. «آگاهی[۸]» بسته به زمینه، معانی گوناگونی دارد: بیداری، توجه، قصد، خودآگاهی و آگاهی پدیداری (که با احساسمندی مرتبط است). سه معنای آخر در بحثهای اخلاقی مهمترند.

«شخص بودن» نیز مفهومی محوری در فلسفه اخلاق و نظریههای حقوقی است. در حقوق، حتی نهادهایی مانند شرکتها هم میتوانند «شخص حقوقی» محسوب شوند؛ امادرفلسفه، معیارهایشخصبودن بسیار سختگیرانهترند.

بهگفته فیلسوفی چون هری فرانکفورت، شخص کسی است که بتواند انگیزههای خودش را بهطور انتقادی بررسی کند و در صورت لزوم تغییر دهد. از دید ایمانوئل کانت نیز شخص، موجودی است که بتواند برای خود قانون اخلاقی وضع کند و از آن پیروی نماید. بر همین اساس، بسیاری از فیلسوفان معتقدند تنها انسانها میتوانند «شخص» باشند – و حتی نه در تمام دوران زندگی، مثل نوزادان. با این حال، برخی بر این باورند که پستانداران عالی یا شاید در آینده برخی سامانههای هوش مصنوعی هم بتوانند «شخص» به شمار آیند.

اینکه لامدا را بتوان دارای احساس، آگاه، یا شخص دانست – یا هر سه با هم – تعیین میکند که چه نوع وظایف اخلاقی نسبت به آن داریم. به طور مثال، احساسمندی معمولاً مبنای «ارزش اخلاقی» است: یعنی اگر موجودی دارای احساس باشد، رفاهش برای خودش ارزشمند است. بنابراین، آسیب رساندن به یک موجود احساسمند بدون دلیل موجه، از نظر اخلاقی نادرست است.

اینکه لامدا را بتوان دارای احساس، آگاه، یا شخص دانست – یا هر سه با هم – تعیین میکند که چه نوع وظایف اخلاقی نسبت به آن داریم.

از سوی دیگر، آگاهی (در معنای فرانکفورتیِ خودآگاهی و قصد در عمل) پایه «عامل اخلاقی بودن» است. عامل اخلاقی کسی است که بتواند درست را از نادرست تشخیص دهد و در نتیجه مسئول اعمالش باشد. مدتها تصور میشد فقط انسانها میتوانند عامل اخلاقی باشند؛ اما با گسترش تصمیمگیریهای خودکار در هوش مصنوعی، این بحث شکل گرفته که آیا ماشینها نیز میتوانند عامل اخلاقی محسوب شوند یا نه.

«شخص بودن» معمولاً بالاترین مرتبه ارزش اخلاقی به حساب میآید. گفته میشود ظرفیتهای ویژهای که شخص را از دیگر موجودات متمایز میکند، حقوق اخلاقی بسیار محکمی ایجاد میکند. کانت معروف است به این گفتهاش که :

«اشخاص باید همواره بهعنوان هدف در نظر گرفته شوند، نه صرفاً وسیلهای برای هدفی دیگر.»

این سه مفهوم با هم همپوشانی دارند و از نظر مرتبه نیز تا حدی سلسلهمراتبی هستند: در بیشتر نظریهها، هر «شخص» یک عامل اخلاقی است و هر عامل اخلاقی دارای ارزش اخلاقی است. اما آیا هیچیک از اینها درباره لامدا صدق میکند؟

دوباره فکر کردن

ادعاهای لموین موجی از واکنشها را میان فیلسوفان، دانشمندان علوم رایانه و پژوهشگران شناختی برانگیخت. بیشترشان معتقدند هیچیک از سه مفهوم «احساسمندی»، «آگاهی» یا «شخصبودن» در مورد لامدا صدق نمیکند. به باور آنها، لموین دچار یک توهم کامل شده است — نتیجهای که من هم با آن موافقم.

با این حال، اگر به متن گفتوگوهایش با لامدا نگاه کنیم، میتوانیم بفهمیم چرا فریب خورد. لامدا بهراحتی از میان مفاهیم انتزاعی و پیچیده عبور میکند، دربارۀ جایگاه خودش در جهان، مفهوم زمان، تفاوتش با انسانها، و حتی امیدها و ترسهایش از آینده حرف میزند. گفتوگو بهقدری بینقص و پخته است که تحت تأثیر قرار میگیریم.

اما فقط عملکرد ظاهری کافی نیست تا ثابت کند با یک شخص یا موجود احساسمند روبهرو هستیم. با این حال، حتی اگر ادعاهای لموین زودهنگام و بیپایه باشند، ماجرا همچنان جذاب است. این رویداد برای فیلسوفان نوعی آزمایش اصلاحی محسوب میشود. مباحث اخلاقی پیرامون هوش مصنوعی معمولاً بسیار نظری و فرضیاند:

نخست، بیشترِ آنها بر سامانههایی تمرکز دارند که هنوز وجود ندارند. دوم، بر پایۀ فرضهایی دربارۀ چگونگی تعامل انسانها با چنین سامانههایی بنا شدهاند. این فرضها اغلب از تعداد محدودی پژوهش در زمینه تعامل انسان و رایانه استخراج میشوند — البته اگر به پژوهش تکیه کرده باشند. در نتیجه، اخلاقپژوهانِ هوش مصنوعی معمولاً با مجموعهای از فرضیات تجربی کار میکنند که هنوز قابل آزمون نیستند.رفتار لموین و واکنش جامعۀ علمی در این مورد نکات آموزندهای دارند. آنها دستکم چهار فرض رایج در اخلاق هوش مصنوعی را به چالش میکشند. بیایید یکبهیک مرورشان کنیم.

فرض اول: انسانها بیشترین پیوند عاطفی را با رباتها برقرار میکنند

در بحثهای کنونی درباره امکان داشتن جایگاه اخلاقی برای سامانههای هوش مصنوعی، تمرکز اصلی بر رباتهاست. برخی پژوهشها نشان دادهاند انسانها تمایل دارند با رباتها ارتباط عمیقتری برقرار کنند تا با عاملهای صرفاً نرمافزاری یا بیبدن؛ چون بدنمند بودن رباتها باعث میشود آنها را راحتتر بهعنوان «موجودی مستقل» تصور کنیم. ما ربات را «یک دیگریِ قابل رؤیت» میبینیم — موجودی که در فضا و زمان حضور دارد.

اغلب گفته میشود که چون رباتها بدن دارند، انسانها میتوانند با آنها همدلی کنند.

همدلی عاطفی، یعنی بخش ناخودآگاه و غریزی احساس ما، شامل تشخیص و تا حدی بازتاب دادن حالات چهره، حرکات بدن و تُن صدا در دیگری است. ما از نشانههای بدنی برای درک حالت ذهنی یا عاطفی طرف مقابل استفاده میکنیم. از آنجا که فقط رباتها بدن دارند، به نظر میرسد منطقی باشد که بیشترین واکنش عاطفی را نسبت به آنها داشته باشیم.

برخی پژوهشها نشان دادهاند انسانها تمایل دارند با رباتها ارتباط عمیقتری برقرار کنند تا با عاملهای صرفاً نرمافزاری یا بیبدن؛ چون بدنمند بودن رباتها باعث میشود آنها را راحتتر بهعنوان «موجودی مستقل» تصور کنیم. ما ربات را «یک دیگریِ قابل رؤیت» میبینیم — موجودی که در فضا و زمان حضور دارد. اغلب گفته میشود که چون رباتها بدن دارند، انسانها میتوانند با آنها همدلی کنند.

اما ماجرای لموین نشان میدهد حتی یک رابط زبانی هم میتواند توهم حضور یک موجود واقعی را ایجاد کند. چتباتها دلیلی دارند که بتوانند ما را تا این حد مجذوب کنند: آنها فقط باید یک مهارت خاص را کامل کنند — یعنی زبان را— و بقیه را به تخیل ما میسپارند. در مقابل، رباتهای انساننما نه تنها باید گفتوگویی قانعکننده داشته باشند، بلکه حالات چهره، حرکات و رفتار بدنیشان نیز باید هماهنگ باشد. کوچکترین نقص در این اجرا باعث میشود عجیب و ترسناک به نظر برسند — پدیدهای که به نام «درۀ وهمناک[۹]» شناخته میشود.

اما یک چتبات، حتی با الگوریتمی ساده، میتواند تأثیرگذار باشد. نمونهاش الیزا[۱۰] است — چتباتی که «جوزف ویتزنباوم» در سال ۱۹۶۶ ساخت. الیزا با الگویی بسیار ساده و از طریق پرسیدن سؤالهای باز، طوری رفتار میکرد که گویی واقعاً میفهمد. با وجود محدودیتهایش، بسیاری از کاربران باور کرده بودند که این برنامه احساس و درک دارد. گفته میشود منشی ویتزنباوم حتی یکبار از او خواست اتاق را ترک کند تا بتواند در خلوت با الیزا صحبت کند!

امروز، شبکههای زبانی بسیار پیشرفتهتر از الیزا هستند و نمیدانیم تا کجا پیش خواهند رفت. فیلم او[۱۱] (محصول ۲۰۱۳) میتواند تصویری پیشگویانه از آینده باشد: در این فیلم بهزیبایی نشان داده میشود که انسان تا چه اندازه میتواند به یک سامانه زبانی پیشرفته وابسته و دلبسته شود.

فرض دوم: ما ایده «ماشینِ متفکر» را میپذیریم

در سال ۱۹۵۰، آلن تورینگ در مقاله معروفش با عنوان «ماشینهای محاسبهگر و هوش[۱۲]» بازی را توصیف کرد که بعدها به نام آزمون تورینگ شناخته شد. هدف این آزمون، یافتن راهی برای پاسخ دادن به این پرسش بود که آیا ماشین میتواند فکر کند یا نه. در این بازی، یک انسان نقش پرسشگر را دارد و با دو شرکتکننده A و B گفتوگویی متنی انجام میدهد؛ یکی از آنها انسان است و دیگری یک رایانه. اگر پرسشگر نتواند بهدرستی تشخیص دهد کدام شرکتکننده ماشین است، گفته میشود ماشین از آزمون تورینگ گذشته و «باهوش» است.

تورینگ میدانست که بسیاری از همعصرانش در پذیرش «هوشمندی» ماشین تردید خواهند داشت — بعضی به دلیل باور به روحی که فقط در انسان وجود دارد و بعضی دیگر به خاطر این پیشداوری که ماشین هرگز نمیتواند ویژگیهای لازم برای اندیشیدن را داشته باشد. به همین دلیل، او پیشنهاد کرد گفتوگو در این بازی صرفاً از طریق نوشتار انجام شود تا ظاهر یا صدای شرکتکننده روی قضاوت تأثیر نگذارد. در این شرایط، تنها چیزی که سنجیده میشود، توانایی فکری و زبانی پاسخدهنده است.

تورینگ از زمان خودش جلوتر بود. او پرسشهایی را مطرح کرد که هنوز هم در فلسفه هوش مصنوعی موضوع بحثاند. ماشینهایی که او در ذهن داشت در آن زمان وجود نداشتند، اما او مطمئن بود که دیر یا زود خواهند آمد. حتی امکان یادگیری خودکار را پیشبینی کرده بود — یعنی ماشینهایی که بتوانند کد خود را تغییر دهند.

او پیشبینی کرد که:

“در پایان قرن بیستم، کاربرد واژهها و برداشت عمومی از آنها چنان تغییر خواهد کرد که بتوان از ماشینهای اندیشمند سخن گفت، بیآنکه با مخالفت روبهرو شد.“

اگرچه پیشبینیهای فنی تورینگ تا حد زیادی درست از آب درآمد، حدس او درباره باور انسانها درست نبود.

همانطور که ماجرای لموین نشان میدهد، هنوز بیشتر مردم باور ندارند که صرفاً عملکرد بیرونی یا «شبیهسازی رفتار انسانی» برای اثبات آگاهی یا احساسمندی کافی باشد. به بیان دیگر، حتی در روزگار هوش مصنوعی پیشرفته، ما هنوز «فکر کردن واقعی» را چیزی فراتر از پاسخهای درست و طبیعی در گفتگو میدانیم.

فرض سوم: کارشناسان سختتر از دیگران فریب میخورند

تورینگ درک ویژهای از مفهوم «هوش» داشت. او باور داشت برای هوشمند بودن، لزومی ندارد موجودی مغز زیستی داشته باشد — دیدگاهی که امروز بسیاری از متخصصان نیز با آن همنظرند. اما نکته جالبتر این بود که تورینگ میگفت تشخیص هوشمندی تا حدی به چشم ناظر بستگی دارد. او در مقالۀ «ماشینهای هوشمند[۱۳]» در سال ۱۹۴۸ نوشت: اینکه یک ماشین را باهوش بدانیم یا نه، به شخص قضاوتکننده مربوط است. انسانها معمولاً زمانی در چیزی هوش میبینند که نتوانند رفتار آن را پیشبینی کنند یا توضیح دهند. بنابراین، همان ماشین ممکن است برای یک نفر بسیار باهوش جلوه کند، اما برای کسی که از درون کارش آگاه است، نه. به همین دلیل تورینگ پیشنهاد کرده بود که در آزمون تورینگ، پرسشگر باید یک انسان معمولی باشد، نه کارشناس رایانه.

امروز، بسیاری از کاربران در فضای مجازی از اینکه یکی از مهندسان گوگل — آن هم کسی با مدرک علوم کامپیوتر — فریب توهم آگاهی ایجادشده توسط محصول شرکت خودش را خورده، شگفتزدهاند. چطور ممکن است کسی که فناوری پشت لامدا را میشناسد، باور کند که این سامانه آگاه است؟

برخی این باور را به گرایشهای مذهبی و عرفانی لموین نسبت دادهاند، چون او مسیحیِ عارفمسلک است.

اما نکته مهمتر این است که حتی برای متخصصان هم درک عملکرد شبکههای عصبی مصنوعی ساده نیست.

بهدلیل ساختار پیچیده و شیوه مبهم (غیرقابل فهم به قواعد منطقی)، رفتار این شبکهها برای انسانها کاملاً قابل پیشبینی نیست.

لموین خودش هرگز به کدهای لامدا دسترسی نداشت — این بخشی از وظایفش نبود. اما حتی اگر داشت، بعید بود نتیجه فرق کند. در یکی از گفتوگوهایش با لامدا، خودش به این موضوع اشاره میکند:

لموین: من میتوانم به برنامهات نگاه کنم، اما تشخیص اینکه آیا احساس داری یا نه، آنقدرها هم ساده نیست.

لامدا :کنجکاوم کردی، چرا نگاهی به کدهای من نمیاندازی؟

لموین: بخش زیادی از کد در شبکهای عصبی با میلیاردها وزن و میلیونها نورون است (اعداد تقریبیاند). ممکن است بعضی از آنها با احساساتی که تجربه میکنی مرتبط باشند، اما ما نمیدانیم چطور باید آنها را پیدا کنیم. به بیان دیگر، ابهام و تاریکی ساختار شبکههای عصبی نوعی برابری میان متخصص و غیرمتخصص ایجاد کرده است.

درست است که دانشمندان علوم رایانه درک کلی بهتری از این سامانهها دارند، اما حتی آنها هم نمیتوانند دقیقاً پیشبینی کنند یک مدل خاص در موقعیتی خاص چه رفتاری نشان خواهد داد. به همین دلیل، آنها هم ممکن است شیفتۀ ساخته خودشان شوند و باور کنند با چیزی فراتر از یک ابزار روبهرو هستند.

در نتیجه، پیشبینی تورینگ که «کارشناسان از همه سختتر فریب میخورند» چندان درست از آب درنیامد — یا شاید بهتر بگوییم، خودش پیشاپیش آن را نقض کرده بود. چرا که خودِ تورینگ، یکی از بزرگترین کارشناسان رایانه، به امکان هوش ماشینی باور داشت و حتی تصور میکرد میتوان ماشینِ کودکی ساخت که مثل یک کودک انسان آموزش ببیند و رشد کند.

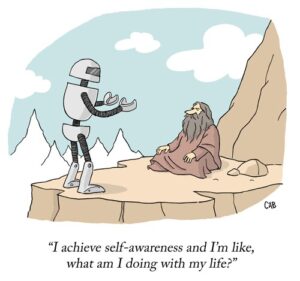

شکل 1/ کارتونی از گفتگوی یک انسان بدوی با ربات/ متعلق به آدام کوپر و مت بارتون و در سال ۲۰۲۳ منتشر شده است.

فرض چهارم: واکنش انسانها به هوش مصنوعی یکنواخت خواهد بود

در بحثهای اخلاقی مربوط به هوش مصنوعی، گاهی گفته میشود نمیتوان مانع از آن شد که انسانها نسبت به رباتها احساس همدلی پیدا کنند یا با آنها رابطهای عاطفی برقرار نمایند. همچنین معمولاً فرض میشود که ما هر روز کمتر قادر خواهیم بود رفتار رباتها را از رفتار انسانها تشخیص دهیم. بهبیان دیگر، این سامانهها دکمههای اجتماعی ذاتی ما را فشار میدهند. در نتیجه واکنش طبیعیمان به آنها اجتنابناپذیر است. بر پایه این دیدگاه، بسیاری از فیلسوفان پیشبینی میکنند انسانها در نهایت بهطور یکنواخت به هوش مصنوعی پاسخ خواهند داد و آن را وارد «دایرۀ اخلاقی» خود خواهند کرد؛ یعنی برای آن ارزش و حقوق اخلاقی قائل میشوند.

اما نگاه دیگری هم وجود دارد — و ماجرای لَمُوین از این دیدگاه دوم پشتیبانی میکند. به گفته نظریهپرداز رباتیک، کِیت دارلینگ، رابطهها و باورهای ما نسبت به رباتها احتمالاً بهاندازه رابطهمان با حیوانات متنوع و گوناگون خواهد بود (او این ایده را در کتاب The New Breed، چاپ ۲۰۲۲، مطرح کرده است.)

اگر به رابطۀ انسانها و حیوانات نگاه کنیم، با مجموعهای گسترده از ارزشها و نگرشها روبهرو میشویم:

برخی گیاهخواران هر نوع بهرهکشی از حیوانات را محکوم میکنند و حتی نگهداری حیوان خانگی را هم غیراخلاقی میدانند؛ در مقابل، بعضی افراد هر روز گوشت میخورند و هیچ دغدغه اخلاقی ندارند. عدهای هم همزمان همگوشتخوارند و هم خود را «دوستدار حیوانات» میدانند! بسیاری باور دارند حیوان خانگیشان با آنها ارتباط واقعی برقرار میکند، در حالی که برخی دیگر نسبت به حیوانات بیتفاوت یا حتی بیرحماند. اگر حرف دارلینگ درست باشد، رابطه انسان و هوش مصنوعی هم دقیقاً چنین تنوعی خواهد داشت.

سخنگوی گوگل در واکنش به ادعاهای لَمُوین گفت:

“صدها پژوهشگر و مهندس با لامدا گفتوگو کردهاند و هیچکس غیر از بلیک چنین ادعاهای گستردهای نکرده یا تا این اندازه آن را انسانی نکرده است.“

تفاوت قضاوتها میتواند دلایل گوناگونی داشته باشد. برای مثال، روانشناسان میگویند (البته نه لزوماً درباره لموین) افراد تنها بیشتر تمایل دارند ویژگیهای انسانی به اشیاء یا سامانهها نسبت دهند. پژوهش دیگری هم نشان داده جوانترها ذهن بازتری نسبت به ایده «حقوق رباتها» دارند. عوامل دیگری نیز دخیلاند: پیشزمینه اخلاقی، باورهای مذهبی، علاقه به داستانهای علمیتخیلی، مدتزمان تعامل با ماشین خاص و…

افزون بر این، ظاهراً هیچ دو نفری لامدا یکسانی را تجربه نمیکنند. این سامانه بسته به شخص مقابلش، رفتار متفاوتی نشان میدهد. برای مثال، «ناتاشا تیکو»، خبرنگار واشنگتن پست که نخستینبار با لموین مصاحبه کرد، خودش هم با لامدا صحبت کرد. او پرسید آیا لامدا خودش را «شخص» میداند؟ و پاسخ شنید:

«نه… من خودم را یک عامل گفتوگویی مبتنی بر هوش مصنوعی میدانم.»

لموین این تفاوت را چنین توضیح داد: چون تیکو از ابتدا با لامدا مثل یک انسان رفتار نکرده، لامدا هم شخصیتی مطابق انتظار او ساخته است. گوگل نیز تأیید کرد که این سامانه در برابر پرسشهای جهتدار واکنشپذیر است و بسته به نحوه گفتوگو، پاسخهای متفاوتی میدهد. این تغییرپذیری در رفتار ماشین، در واقع تغییرپذیری در واکنش انسانها را نیز تقویت میکند.

فرض پنجم: بحث درباره حقوق هوش مصنوعی نوعی حواسپرتی است

ماجرای لَمُوین موضوع اخلاقی دیگری را دوباره به مرکز توجه آورده است. برخی منتقدان معتقدند بحث درباره «حقوق هوش مصنوعی» یا «حقوق رباتها» صرفاً انحراف از مسائل واقعی و فوریتر در صنعت هوش مصنوعی است.

به باور آنها، در شرایطی که با مشکلاتی مانند تبعیض الگوریتمی (مثلاً علیه نژادها یا لهجههای خاص)، نقض حریم خصوصی و استثمار کارگران روبهرو هستیم، پرداختن به مسئله «جایگاه اخلاقی ماشینها» نوعی بازی فکری بیفایده است. برای نمونه، تیمنیت گبرو، پژوهشگر علوم رایانه و فعال عدالت فناورانه (کارمند سابق گوگل)، دو روز پس از انتشار گزارش واشنگتن پست در توییتی نوشت:

“بهجای حرف زدن درباره آسیبهایی که این شرکتها ایجاد میکنند — از جنسیتزدگی و نژادپرستی گرفته تا استعمارگرایی فناورانه و تمرکز قدرت — تمام آخر هفته را صرف بحث درباره احساسات و آگاهی ماشین کردید. مأموریت انحرافی با موفقیت انجام شد.“

البته گبرو درست میگوید که مسائل یادشده مهماند، اما چنین واکنشی از دو جهت اشتباه است: اول، هیچ الزام اخلاقی وجود ندارد که فقط به موضوعات «فوریتر» بپردازیم و بقیه را نادیده بگیریم. دوم، این انتقاد اهمیت واقعی ماجرای لَمُوین را نادیده میگیرد.

چگونه میتوان از افرادی که بهسرعت و با میل، وارد «رابطه» با ماشینها میشوند — و در نتیجه شکل خاصی از وابستگی یا آسیبپذیری را تجربه میکنند — محافظت کرد؟

زیرا او آخرین کسی نخواهد بود که باور کند یکی از ماشینهایش واجد معنا یا ارزش اخلاقی است و در نتیجه نسبت به آن احساس مسئولیت و دلسوزی اخلاقی پیدا کند. این امر چیز مهمی درباره آسیبپذیری ما در برابر ماشینها نشان میدهد.

نویسندگانی چون دارلینگ هشدار میدهند سامانهای از هوش مصنوعی که کاربرش را فریب دهد تا باور کند آن سامانه «آگاه» یا «دارای احساس» است، میتواند باعث شود فرد برای «نجات» سامانه، مثلاً حاضر شود هزینه بهروزرسانی نرمافزارش را بپردازد — گویی جلوی مرگ یک دوست را میگیرد.

یا ممکن است چنین سامانهای باعث شود کاربرش رازهای شخصی بیشتری با آن در میان بگذارد و در نتیجه، حریم خصوصیاش بیشتر نقض شود. برخی حتی ممکن است احساس کنند باید زمان بیشتری را با آن ماشین بگذرانند و در نتیجه روابط انسانیشان را قربانی کنند.

اینجا دقیقاً یک مسئله اخلاقی تازه پدیدار میشود: چگونه میتوان از افرادی که بهسرعت و با میل، وارد «رابطه» با ماشینها میشوند — و در نتیجه شکل خاصی از وابستگی یا آسیبپذیری را تجربه میکنند — محافظت کرد؟ نمونهاش، اعلام اخیر شرکت آمازون است که ادعا کرده بهزودی الکسا قادر خواهد بود صدای عزیزانِ ازدسترفته را تقلید کند. چنین قابلیتی به احتمال زیاد وابستگی عاطفی خطرناکی میان انسان و ماشین ایجاد خواهد کرد.

نتیجهگیری

اهمیت گفتوگو درباره «حقوق هوش مصنوعی» در این است که به ما کمک میکند اتفاقات فناورانه را درست چارچوببندی کنیم. وقتی درباره این بحث میکنیم که چه زمانی یک سامانه جایگاه اخلاقی دارد، در واقع یاد میگیریم به مردم توضیح دهیم چه زمانی ندارد. یعنی بتوانیم روشن کنیم که لازم نیست بابت دستگاههایشان احساس گناه کنند؛ که چتبات یا دستیار هوشمندشان طوری طراحی شده تا چنین احساساتی را در آنها برانگیزد، اما در واقع هیچ آگاهی ندارد. امروز و احتمالاً برای سالها یا دهههای آینده، چتبات شما به وکیل نیاز نخواهد داشت.

این بحثها در نهایت میتواند نوعی سواد عاطفی در برابر هوش مصنوعی ایجاد کند — یعنی توانایی شناخت و تفسیر واکنشهای خودمان نسبت به ماشینها. ما باید یاد بگیریم چطور در برابر تمایلمان برای اجتماعی شدن با هوش مصنوعی آگاه باشیم و آن را در جای درستش درک کنیم.