شرکتهای فنی، جوامع حرفهای و مؤسسات آکادمیک در مورد ایجاد هیأتهای اخلاقی و تهیه پیشنویس اصول هوش مصنوعی، تنظیم شده و سیاستگذاران شروع به تدوین قوانین و مقررات هوش مصنوعی، مانند آییننامه عمومی حفاظت از دادهها[۱] در اروپا و قانون حریم خصوصی مصرفکننده در کالیفرنیا، کردهاند. این مراحل به دقت نمایانگر چگونگی ظهور معیارهای اخلاقی در زمینههایی مانند تحقیقات زیست پزشکی است، که به دلیل عدم وجود قوانین اخلاقی از ابتدا، متزلزل شده است.

چارچوب اخلاقی که برای تحقیقات زیستپزشکی شکل گرفت –یعنی مدل نظارت و انطباق اخلاق[۲]– در واکنش به وحشتهای ناشی از تحقیقات پزشکی در طول جنگ جهانی دوم، توسعه یافته و تا دهه 70 ادامه یافت.

در پاسخ، برای پیشگیری از تحقیقات غیراخلاقی، اصول اخلاق زیستشناختی و هیأتهای بازبینی اخلاقی پایبند به این اصول، ایجاد شدند. در این فرآیند، به این هیأتها، مسئولیت سنگینی برای اصلاح تحقیقات بدون بررسی و تغییرات برای کنترل آنها، داده شد. شاید عدم وجود رقابت، باعث شد تا این مدل، با وجود ضعفهای نظری عمیق در چارچوب و مشکلات عملی گسترده در اجرای آن، به مدل حاکمیت پیشفرض اخلاق تبدیل شود.

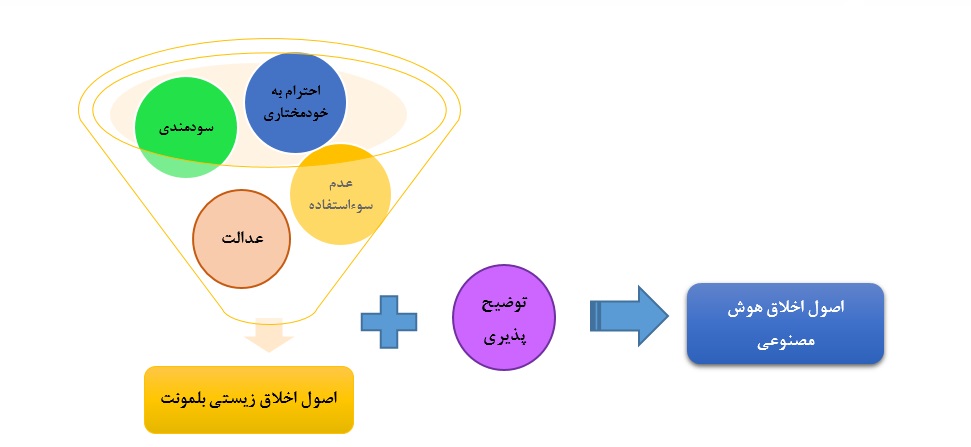

چارچوبی که در حال حاضر برای اخلاق هوش مصنوعی به وجود آمده است، شباهت زیادی به این مدل دارد. در واقع، آخرین مجموعه از اصول هوش مصنوعی، که توسط AI4People[۳] شکل گرفته است و مبانی شکلگیری پیشنویس اصول اخلاقی گروه تخصصی کمیسیون اروپا در زمینه هوش مصنوعی را تشکیل میدهد، 47 اصل پیشنهادی را ارزیابی کرده و آنها را در پنج اصل خلاصه میکند.

چهار مورد از آنها، دقیقاً همان اصول اخلاق زیستی سنتی هستند که در گزارش بلمونت که در سال 1979، ارائه شده، تعریف شدهاند: احترام به خودمختاری[۴]، سودمندی[۵]، عدم سوءاستفاده[۶] و عدالت[۷]، فقط یک اصل جدید تحت عنوان «توضیحپذیری[۸]»، به آن اضافه شده است. اما این مورد نیز در واقع، خود به عنوان یک اصل محسوب نمیشود، بلکه وسیلهای برای تحقق اصول دیگر است. به عبارت دیگر، مدل پیشفرض در حال ظهور، برای اخلاق در حوزه هوش مصنوعی، پیوند و انتقال مستقیمی از اصول و هیأتهای اخلاق زیستی، به اخلاق هوش مصنوعی، است. متأسفانه، برای یکپارچگی مؤثر و معنیدار اخلاق در حوزه هوش مصنوعی، چیزهای زیادی مورد انتظار است.

کنترل اخلاقی در مقابل یکپارچگی اخلاق

مدل سنتی نظارت و انطباق اخلاق، چه زمانیکه در تحقیقات زیست پزشکی بکار رود چه در هوش مصنوعی، دو مشکل عمده دارد. نخست، لیستی از اصول راهنما، خواه 4 یا 40 مورد، تنها نگرانیهای اخلاقی مهم را خلاصه میکند، بدون اینکه به حل مشکلات تعارض بین آنها، بپردازد.

در رابطه با تعارضات موجود بین اصول، برای مثال، توسعه یک ابزار تشخیص در هوش مصنوعی به منظور نجات جان افراد، تحت عنوان مربی بهداشت هوش مصنوعی، نیازمند دسترسی به مجموعه بزرگی از دادههای شخصی است. اصل احترام به استقلال، یعنی احترام گذاشتن به تصمیمات منطقی، آگاهانه و داوطلبانه هر فرد، در مورد خود و زندگی شخصیش، لزوم اخذ رضایت فرد، برای استفاده از آن دادهها را مطرح میکند. در حالیکه چنانچه اصل سودمندی، به معنای انجام کار خوب، مدنظر قرار گیرد، مستلزم این است که این ابزار در سریعترین شکل ممکن، برای کمک به کسانی که در رنج هستند، توسعه یابد. حتی اگر این به معنای چشمپوشی از رضایت افراد باشد. هر هیأت اخلاقی که صرفاً به این اصول اتکا کند، به طور اجتنابناپذیری با یک تعارض اخلاقی مواجه خواهد شد، چرا که هیچ سلسلهمراتبی برای درجهبندی این اصول وجود ندارد.

دوم، تصمیماتی که توسط این هیأتها گرفته میشود، به خودی خود مسئلهساز است. هیأت اخلاقی، کاملاً از محققان دور هستند و به عنوان تصمیمگیرندگانی قدرتمند عمل میکنند. زمانیکه هیأت اخلاقی تصمیمی بگیرد، معمولاً هیچ فرآیند تجدیدنظری وجود ندارد و هیچ مرجع دیگری نمیتواند تصمیم آنها را تنفیذ کند. این مدل، بدون اصول راهنما و فرآیند مناسب، از هیأتهای اخلاقی، برای کنترل محققان استفاده میکند. این امر دلالت بر این دارد که محققان نمیتوانند مورد اعتماد باشند و تنها بر مسدود کردن مواردی که هیأت اخلاقی، آن را غیراخلاقی بداند، تمرکز میکنند.

ما میتوانیم مدل بهتری برای اخلاق هوش مصنوعی ایجاد کنیم. مدلی که اصول اخلاقی را تکمیل کرده و تحقیق و توسعه را افزایش میدهد و در آن، محققان به عنوان همکاران مورد اعتماد، در کنار اخلاقشناسان باشند. این امر نیازمند تغییر تمرکز ما از اصول و هیأتهای اخلاقی به استدلال اخلاقی و کار تیمی است. به عبارتی تغییر از سمت کنترل اخلاقی به یکپارچگی و ادغام اخلاقی مدنظر است.

اخلاق، بخشی از فرآیند توسعه و تحقیق است، خواه صراحتاً قابل تشخیص باشد یا نه. به همین دلیل، استدلال میشود که یک مدل مناسب برای یکپارچهسازی مؤثر اخلاق در فرآیند تحقیق و توسعه، مدلی است که مشکلات اخلاقی را حل کرده و یا حداقل با استفاده از ترکیبی از اصول اخلاقی و ابزارهای طراحی، مشکلات اخلاقی را کاهش دهد. چارچوب اخلاق هوش مصنوعی که در آزمایشگاه اخلاق هوش مصنوعی فوربز[۹]، توسعه پیدا کرده است، مشاغل را نیازمند تمرکز بر سه مؤلفه اصلی می داند: آگاهی و درک اخلاق در شرکت، تعبیه تجزیه و تحلیل اخلاقی در فرآیند طراحی و توسعه و توسعه سیاستهای شرکت برای پرسشهای مهم و حیاتی اخلاقی.

۱. درک اخلاق

توسعهدهندگانی که در حال ساخت و ایجاد سیستمهای هوش مصنوعی هستند، در موقعیتی منحصربهفرد قرار دارند و میتوانند در حین کار روی یک پروژه، مشکلات اخلاقی موجود را تشخیص دهند. اگر آنها نگرانیهای اخلاقی موجود در مورد فناوری که بر روی آن کار میکنند، ارتباطات و تعارضات بین این نگرانیها و چگونگی ویژگیهای آنها در کاربردهای عملی را درک کنند، این افراد میتوانند «اولین پاسخدهندگان» باشند.

درک این نکته نیز مهم است که اخلاق شامل استدلال تحلیلی، ساختاری و نظاممند است. محققان در حال آموزش و توسعهدهندگان با توان ریاضیاتی بالا، به کمک مهارت خود، به آنها این امکان را میدهند تا با یادگیری مفاهیم اخلاقی و تجزیه و تحلیل ارزش، از طریق ابزارهای مشترک مانند منطق به تفکر اخلاقی نزدیک شوند.

به عنوان مثال، تصور کنید در حال توسعه یک ابزار، به عنوان مربی بهداشت، از طریق هوش مصنوعی هستید. این اطلاعات با استفاده از اینترنت اشیاء و سیستم عاملهای مربوطه (به عنوان مثال، پوشیدنیها، رسانههای اجتماعی، دستیار خانگی)، تمام اطلاعات مربوط به سلامتی فرد را در 24 ساعت هر روز هفته، جمعآوری میکند و به منظور نشان دادن ترجیحات، ارزشها، نقاط ضعف و اهداف، با پرسیدن سؤالات صریح از کاربر، این دادهها را تکمیل میکند.

با تجزیه و تحلیل تمام این اطلاعات، این ابزار، راهنماییهایی را برای داشتن یک زندگی سالم، در اختیار کاربر قرار میدهد. این مربی هوش مصنوعی، به عنوان مکمل روشهای بهداشت و سلامت سنتی، با تجزیه و تحلیل تمام دادههای مرتبط در زمان واقعی و امکان هشدار فوری به کاربر در صورت بروز هرگونه مشکل، ابزاری بسیار مفید خواهد بود.

با این حال، طراحی چنین ابزاری شامل موضوعات اخلاقی مختلفی میشود. اول از همه، با دادههای بسیار خصوصی سروکار دارد و این دادهها نه تنها برای کاربر بلکه برای طرفهای دیگر مانند شرکتهای بیمه و کارفرمایان که لزوماً بهترین منافع کاربر را در نظر نمیگیرند، مورد توجه قرار خواهد گرفت. علاوه بر این، اگر این ابزار برای هدایت مؤثر تغییر رفتار طراحی شده باشد، میتواند از روشهای فریبکارانه و دستکاری نیز استفاده کند.

در طراحی چنین مربی هوش مصنوعی، مهم است که توسعهدهندگان، مشکلات اخلاقی مانند شناسایی و تعیین نگرانیهای حریم خصوصی در مورد این دادههای خصوصی (چه در نحوه جمعآوری این دادهها و چه در چگونگی به اشتراک گذاشتن آنها)، نگرانی در رابطه با خودمختاری در روشهای دستکاری، و حتی عدالت در دادههای آموزشی برای اجتناب از عدم تعادل جنسیتی یا نژادی که میتواند منجر به نرخ خطای بالاتر برای گروههای خاص شود، را در نظر بگیرند.

در آزمایشگاه اخلاق هوش مصنوعی، به توسعهدهندگان آموزش داده میشود تا مشکلات اخلاقی را تشخیص داده و از طریق کارگاهها و سمینارها، در استدلال اخلاقی مهارت پیدا کنند. بنا بر گزارشها، گوگل رویکرد مشابهی را از طریق مجموعه سخنرانی اخلاق در هوش مصنوعی، برای آموزش اخلاق به کارمندان خود، اتخاذ کردهاست.

۲. تجزیهوتحلیل اخلاقی

تشخیص مشکلات اخلاقی کافی نیست، ما باید آنها را حل کنیم. درحقیقت، هدف این است که مشکلات از همان ابتدای بروز تا حل آنها در زمان واقعی، در هر بخش از فرآیند نوآوری، از مرحله تحقیق تا طراحی، توسعه، تولید و حتی بهروزرسانی فنآوری، مدیریت شود. رفع مشکلات، پیش از اینکه به یک مشکل کامل تبدیل شود یا حتی به رسوایی بکشد، نه تنها رویکردی «درست» است، بلکه باعث صرفهجویی در منابع نیز میشود.

هدف این مدل برای یکپارچگی اخلاق، فراتر از اجتناب از پیامدهای غیراخلاقی است. این فناوری، تکنولوژی را ارتقا داده و آن را مفیدتر خواهد کرد. همچنین، حالتی ایدئال برای همه به ارمغان میآورد. تحقق این هدف، تنها در صورتی امکان پذیر است که تجزیهوتحلیل اخلاقیات به بخشی از فرآیند نوآوری و توسعه محصول تبدیل شود، و متخصصان اخلاق، به عنوان کارمند یا مشاور، بخشی از تیمهای پروژه شوند.

در حالیکه توسعهدهندگان، میتوانند به تعیین مشکلات اخلاقی کمک کنند، اما از آنجا که آنها متخصص اخلاق نیستند، نمیتوانند کاملاً مسئول باشند. اخلاقشناسان، میتوانند این مسئولیت را با همکاری توسعهدهندگان، انجام دهند و مسئولیت شناسایی مشکلات اخلاقی و همچنین شفافسازی و حل آنها را، در حد توان خود تقسیم کنند. با این طراحی، این مدل یک مدل مشارکتی خواهد بود و این ساختار مشارکتی مزایای جانبی نیز دارد: این مدل، توسعهدهندگان و اخلاقشناسان را قادر میسازد تا از یکدیگر یاد بگیرند.

اگر به مثال مربی بهداشت هوش مصنوعی برگردیم، در فرآیند طراحی و توسعه این ابزار، باید به چند سؤال اخلاقی پاسخ داده شود: ساختار رضایت چگونه باید طراحی شود تا اطمینان حاصل شود که کاربران نه تنها در اشتراک گذاری دادههای خود، بلکه در استفاده از مربی هوش مصنوعی نیز تصمیمات آگاهانه میگیرند؟ چگونه بین نگرانیهای مختلف مربوط به سلامت، که توسط اولویتهای فردی و سلامت عمومی ایجاد شده است، تعادل برقرار شود؟ چگونه باید بدون نقض استقلال فردی، به افراد در غلبه بر مشکلات انگیزشیشان کمک کرد؟ در شرکت فوربز، برای کمک به حل این مشکلات، ما به محققان و توسعهدهندگان مشاوره میدهیم و با آنها همکاری میکنیم تا پروژهها و محصولات خود را توسعه دهند.

۳. سیاست اخلاقی شرکت

آخرین مورد که مهمترین آنها نیز محسوب میشود، سؤالات سخت تکراری است که مشاغل و مؤسسات، در رابطه با آنها نیاز به موضعگیری دارند. سیاست آنها برای همکاری با نیروهای نظامی و انتظامی چیست؟ تحت چه شرایطی باید چنین همکاریهایی تشکیل شود؟ اگر تحقیق و یا محصولات بتواند برای آسیب رساندن استفاده شود، آیا باز هم آنها باید آن را منتشر کرده یا ارائه دهند؟

اگر به مثال مربی بهداشت هوش مصنوعی برگردیم، شرکت تولیدکننده این محصول، باید در مورد خطمشی[۱۰] خود در رابطه با سؤالاتی نظیر اینکه آیا این محصول در دسترس مشاغل تهاجمی یا دولتهای سرکوبگر، که میتوانند از این دادههای محرمانه بر علیه افراد استفاده کنند، قرار بگیرد یا نه، تصمیم بگیرد.

این سؤالات ما را فراتر از مشکلات اخلاقی مرتبط با محصول یا فناوری مرتبط برده و نگرانیهای اخلاقی وسیعتری ایجاد میکند. تیم اخلاق سازمان، نه تنها باید شامل اخلاقشناسان باشد، بلکه باید ذینفعان دیگر بخشها یا رشتههایی که بر روی پرسشهای اخلاقی کار میکنند، را نیز شامل شود. این تیم، باید سیاستهایی را تنظیم کند تا به هدایت هر دو تیم پروژه و راهنما کمک کند. همچنین، بسیاری از سؤالات اخلاقی، بیش از یک پاسخ صحیح دارند. در حالیکه این کثرت مورد قبول است و حتی مورد استقبال قرار میگیرد، اما باید برای جلوگیری از تناقضات عمیق، تصمیماتی اتخاذ شود.

به نظر میرسد امروزه بسیاری از بزرگترین شرکتهای فنآوری، با ایده تأسیس هیأتمدیرهای برای سازماندهی سیاستهای اخلاقی شرکت، مشغول به کار هستند. همه آنها به تشکیل تیمهای اخلاقی پرداخته و اصول هوش مصنوعی خود را منتشر کردهاند و ادعا میکنند، که از طریق این سیاستها، شرکتشان را هدایت میکنند. با اینحال، عموم مردم، هنوز بهخوبی درباره چگونگی تدوین این سیاستها یا چگونگی استفاده از آنها در تصمیمگیری، آگاه نیستند.

نکته اساسی که باید به رسمیت شناخته شود، این است که هیچ یک از موضوعاتی که در اینجا ذکر شده است، مباحث عالی اخلاقی، نیستند. آنها تصمیمات اخلاقی اجرایی هستند و عملی شدن این تصمیمات مستلزم این است، که افراد، از ترجیحات و احساسات اخلاقی فراتر رفته و درگیر استدلال اخلاقی شوند. خوشبختانه، یک بدنه بزرگ فکری برای کمک به ما در استدلال اخلاقی وجود دارد: اصول اخلاقی کاربردی ترسیمی از فسلفه اخلاقی و سیاسی بوده و شامل حوزه وسیعی از دانش، مهارتها، و ابزارهاست که در طول دو هزار سال جمعآوری و تدوین شده است. بنابراین، اگرچه برخی سؤالات در اخلاق هوش مصنوعی، واقعاً جدید هستند، اما در واقع، بسیاری از مسائل اخلاقی که با آن روبرو هستیم، در اخلاق کاربردی، جدید نیستند. ما بایستی از این دانش غنی، برای کمک به حل مشکلات امروز استفاده کنیم.

اگر مسائل مربوط به سیاستهای کلان را در نظر نگیریم، بیشتر مسائل اخلاقی هوش مصنوعی، مشکلات روزمرهای هستند که باید در بازههای فشرده زمانی و در طول توسعه محصول حل شوند. دقیقاً به همین دلیل، اصل اخلاق هوش مصنوعی، بیش از ایجاد یک هیأت اخلاقی ناظر بر تحقیق و توسعه، ضرورت دارد.

در نهایت، لازم است که نهادها و شرکتها، چارچوبی برای هدایت تحقیق و توسعه خود اتخاذ کنند. این برنامه، نیازمند آموزش، راهنمایی و هدایت توسعهدهندگان و محققانی است که در بخش نوآوری محصول کار میکنند. البته، کسبوکارها و مؤسسات بزرگتر، منابع بیشتری برای اجرای کامل این مدل دارند. اما حتی استارتآپها، کسبوکارهای نوپا و مراکز رشد و نوآوری، نیز میتوانند، و باید یک چارچوب اخلاقی اتخاذ کرده و آن را در محیط خود ادغام کنند، زیرا آنها محصولاتی مرتبط با فناوری هوش مصنوعی را میسازند، که نه تنها صنعت، بلکه جامعه را نیز تحتتأثیر قرار خواهد داد.